12月第二周AI资讯:google发布多款重磅AI工具

本周,人工智能新闻汇总:

本周,Google DeepMind 发布了全新虚拟世界生成工具 Genie 2,这是一款可以通过自然语言实时生成高度多样化虚拟世界的创新工具。其生成的世界不仅在视觉效果上丰富多样,还能够在逻辑性和连贯性方面保持高度一致。Genie 2 的设计初衷是为通用智能体提供无限动态的训练场景,使智能体能够在多样化的环境中提升应对复杂问题的能力。用户通过键盘和鼠标即可与生成的虚拟世界进行交互,从人物移动、跳跃到探索完整场景,体验都显得流畅且自然。演示视频显示,该工具可以基于 Imagen 3 模型生成的单张图像,扩展生成一个连续一致的动态世界,甚至可以模拟诸如烟雾、重力、水流等物理现象以及灯光照明效果。此外,Genie 2 支持与 NPC(非玩家角色)互动,为虚拟场景的丰富性增添了更多可能性。不过,DeepMind 方面也表示,这款模型仍处于早期研发阶段,未来将在通用性和一致性方面进行优化。

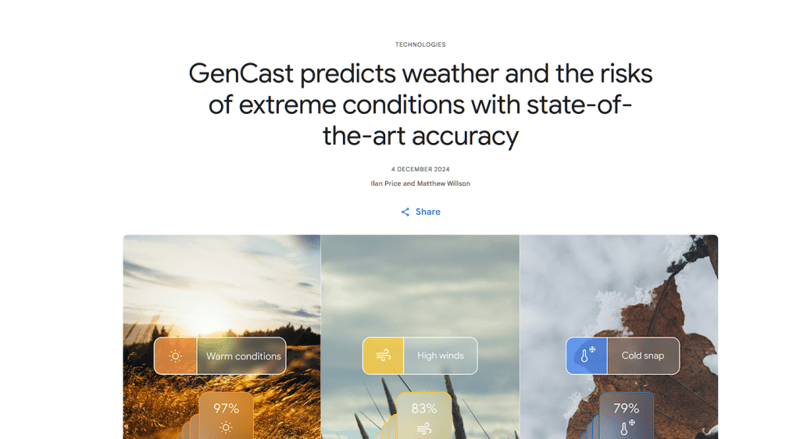

除了 Genie 2,DeepMind 还推出了新一代天气预测模型 Gencast。这一模型在精度和计算效率上取得了重大突破,能够准确预测未来 15 天的天气状况和极端气候风险。相比传统的天气预测系统,Gencast 在多个关键性能指标上超越了现有技术,为应对日益频发的极端气候事件提供了强有力的工具支持。

Google 在视频生成领域也取得了重要进展。本周,其最强的视频模型 VEO 推出私人预览版,具备文本转视频和图像转视频的能力。用户通过简单的文本描述或图像输入即可生成不同风格的高清视频,生成时长可达 60 秒,分辨率最高为 1080p。此外,Google 宣布 Imagen 3 模型的定制化功能将于下周向所有 Google Cloud 用户开放。

这一功能可以将品牌风格和产品特征注入生成图像中,使广告和营销素材的制作更加高效。

在数字人生成领域,阿里云也发布了全新教程和相关 API 接口,进一步降低了数字人技术的使用门槛。通过阿里云的 EMO 工具,用户只需上传一张静态图像,即可生成具有真实表情和动作风格的数字人视频。EMO 支持动作风格强度调节,并允许通过语音或歌曲驱动图像中的人物动作,生成的口型和表情匹配度极高。首次使用阿里云相关大模型服务平台的用户还可获得一定额度的免费使用机会,进一步推动了这一技术的普及化应用。

语音合成技术方面,Fish Audio 发布了其最新的 Fish Speech 1.5 模型。该模型在准确性、稳定性、跨语言能力以及情感表达等方面实现了全面升级,同时新增支持五种语言,进一步扩大了应用范围。Fish Speech 1.5 使用超过 100 万小时的多语言数据进行训练,可支持高质量的即时语音克隆。凭借其在 TTS(文本转语音)领域的表现,该模型已经跻身全球前三。

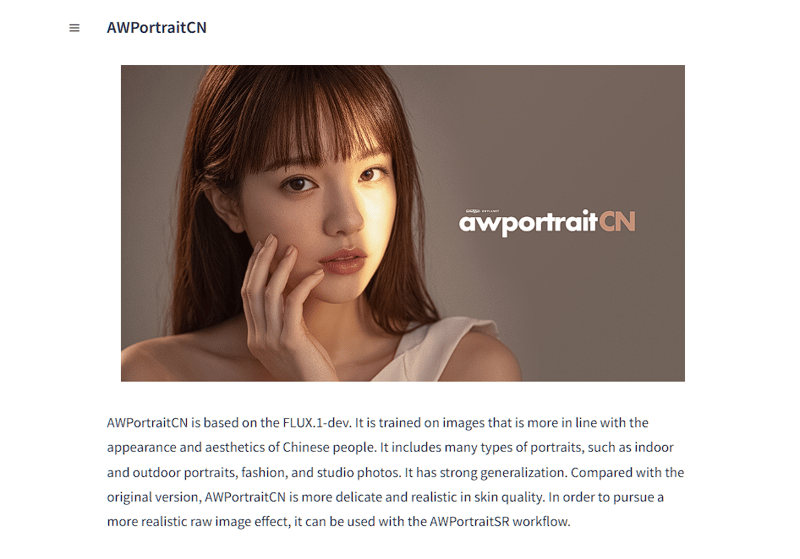

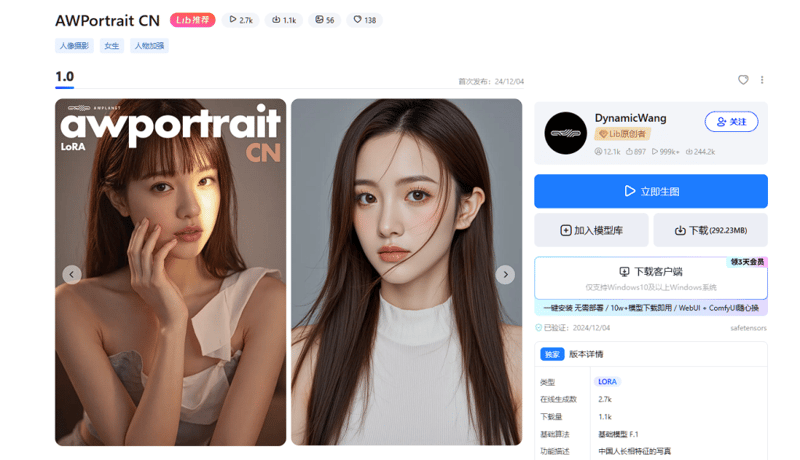

另一项备受关注的发布是 A.W. Portrait CN 模型,这是一款专为中国及东亚市场设计的人像生成模型。基于 Flux 1 Dave 训练,A.W. Portrait CN 更适合生成符合亚洲审美的人像摄影、时尚和摄影棚风格的图像,特别适用于室内场景。模型现已在 LibLib 和 Shaker 平台上线,用户可以免费下载使用。

图像编辑领域,IDEOGRAM 推出了最新的背景移除功能。这一功能不仅能帮助用户快速移除图像背景,还可以选择性地移除特定区域并替换为新的背景内容,目前仅对高级用户开放。完成图像生成后,用户即可通过右侧面板直接使用这一新功能,进一步增强了图像编辑的灵活性。

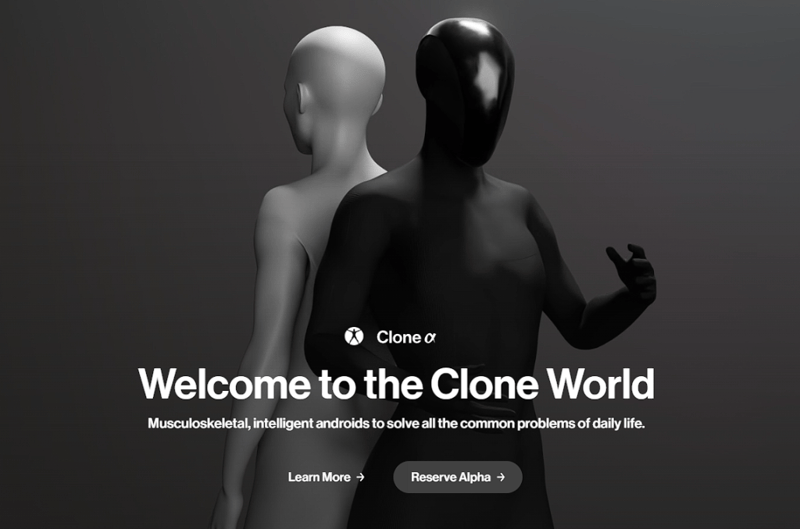

最仿生机器人和全身数字人生成技术也有了新的突破。Colon Robotics 推出的仿生机器人 Clone Alpha 模拟了人类的骨骼、肌肉以及神经系统,其肌纤维的收缩速度甚至快于人类骨骼肌,并通过液压系统驱动肌肉。Clone Alpha 计划于 2025 年开放预订,届时将预装多种功能。