生成深度图的图像模型–ZoeDepth

ZoeDepth是GitHub上一个引人注目的开源深度估计项目,专注于从单幅2D图像中精确预测深度信息。该项目采用了创新的神经网络架构,在保持高精度的同时实现了快速推理。ZoeDepth的核心特征包括多尺度特征融合技术,这显著提高了深度预测的准确性。它的应用范围广泛,从增强现实到3D重建,再到自动驾驶等领域都能发挥重要作用。

作为一个开源项目,ZoeDepth不仅提供了完整的模型代码和预训练权重,还配备了使用示例,大大降低了开发者的使用门槛。此外,它的跨平台特性支持在CPU和GPU上运行,简洁的API设计也使得它易于集成到各种应用中。这些特点使ZoeDepth成为深度估计领域一个极具潜力和实用价值的工具。

ZoeDepth依赖在colab上运行,下面简单介绍一下colab。

Google Colab,全称Google Colaboratory,是一个免费的基于云端的Jupyter笔记本环境,为数据科学家、机器学习工程师和研究人员提供了一个强大而便捷的工作平台。它允许用户在浏览器中编写和执行Python代码,无需本地安装任何软件或配置开发环境。

Colab的一大亮点是提供了免费的GPU和TPU资源,使得用户可以轻松进行深度学习和大规模数据处理任务。它预装了许多常用的数据科学和机器学习库,如TensorFlow、PyTorch和scikit-learn等,大大简化了环境配置的复杂性。此外,Colab支持与Google Drive无缝集成,方便数据的存储和共享,同时其协作功能允许多人实时编辑同一个笔记本。

下面就在colab简单演示一下:

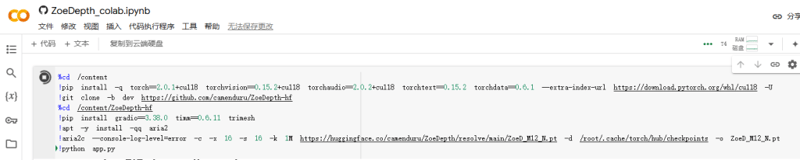

首先打开网页ZoeDepth_colab.ipynb – Colab (google.com),首次登录会提示登录自己的谷歌账号,在此网页点击左侧【三角】运行按钮,colab可以根据代码自动下载依赖和运行库,从而搭建可执行的环境:

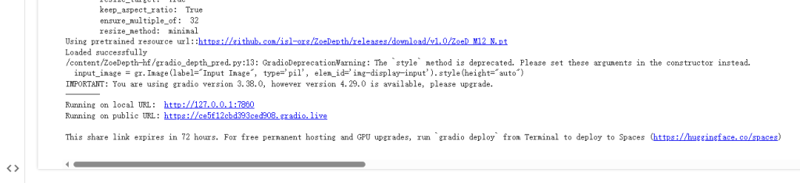

一直等待直到运行完成。在内容提示框内出现可执行链接后说明运行完毕。

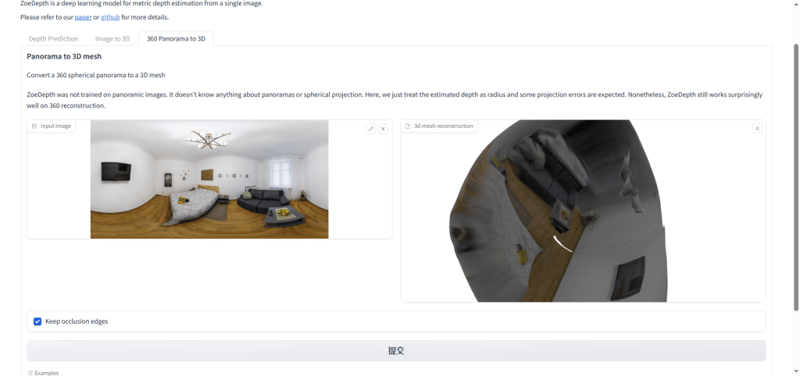

点开public URL,我们在这个新网站上可以尝试一些内容,包括了深度预测、图像转3D、3D全景转3D,即:将360度球形全景转换为3D网格。

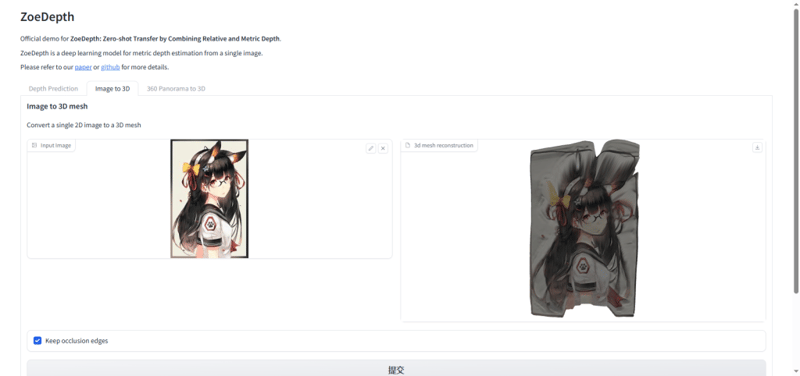

下面我上传一张本地动漫女孩照片,点击提交即可实现,将图片中的女孩以浮雕的方式呈现出来。

深度预测则是根据图片进行判断,即从单张图像中估计度量深度。其实它的实现效果类似于controlnet的depth模型,即生成深度图,那么什么是深度图呢?

深度图是一种二维图像,其中每个像素不是表示颜色,而是表示该点到观察者或摄像机的距离。通常,深度图使用灰度值,即用灰阶数值0-255组成图像,编码距离信息,其中较亮的像素(接近于255一侧)表示较近的物体,较暗的像素(接近于0一侧)表示较远的物体。

深度图在计算机视觉、机器人学和增强现实等领域有广泛应用,它们提供了场景的3D结构信息,可用于物体检测、3D重建、障碍物避免等任务。深度图可以通过特殊的深度相机(如结构光或飞行时间相机)直接获得,也可以通过立体视觉或单目深度估计算法从普通图像中计算得出。在图像处理和计算机图形学中,深度图是理解和操作3D空间的重要工具。

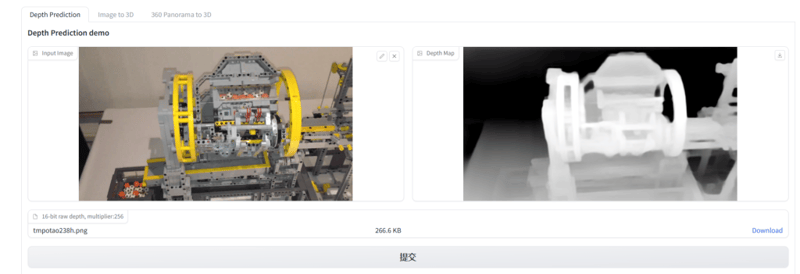

我这里上传了一张乐高模型,让它来实现深度图的绘制,呈现效果如下所示:

从呈现效果上来看,该模型能准确地表达出符合正常逻辑和遵循现实规律的乐高模型深度图。

最后看一下3D全景转3D的实现效果:

它能够将整个屋内的物品以凸显的方式呈现在3D曲面上,正确还原了物品摆放或呈现效果。

感兴趣的同学可以在colab尝试该模型。